Zu Beginn ein kurzer Exkurs in die Physik der letzten Jahrhunderte:

Zum Ende des 18.ten Jahrhunderts waren einige Wissenschaftler berauscht vom wissenschaftlichen Fortschritt der Meinung, sie könnten alle Probleme dieser Welt lösen. Pierre Laplace, ein frz. Mathematiker, der sich durch die Vervollständigung der newtonschen Himmelsmechanik, der Wahrscheinlichkeit- und Spieltheorie verdient gemacht hat und ein konsequenter Vertreter des sog. Determinismus war, vertrat z.B. gegenüber Napoleon die Ansicht, dass man nur genügend Gleichungen aufstellen müsse, um alle Probleme der Welt hinreichend beschreiben und lösen zu können. Da Laplace keine Rechenmaschinen zur Verfügung hatte, brauchte er den Beweis seiner Behauptung nicht antreten, was ihm nach heutiger Kenntnis und dem Vorhandensein enormer Rechenleistungen auch nicht gelungen wäre.

Erste Zweifel am Determinismus – wie Laplace ihn verstand – kamen schon bei der näheren Untersuchung der Planetenbahnen auf. Im Laufe des 19.ten Jahrhunderts entwickelte Ludwig Boltzmann die statistische Thermodynamik und rettete damit kurzfristig den klassischen deterministischen Ansatz der Physik, der dann zu Beginn des 20.ten Jahrhunderts durch die Quantenmechanik endgültig vom Thron gestoßen wurde. Erstmalig mussten die Physiker in der „Heisenbergschen Unschärferelation (Nur zur Erinnerung: Die Heisenbergsche Unschärferelation verknüpft folgende Eigenschaftsänderungen eines quantenmechanischen Teilchens miteinander: ∆p*∆x≥h oder ∆E*∆t ≥h

mit p: Impuls, x: Ort, E: Energie, t: Aufenthaltsdauer und h: Plancksches Wirkungs-quantum)) “ feststellen, dass nicht alle Größen eines Systems gleichzeitig beliebig genau gemessen werden können und dass dies kein behebbares technisches sondern ein grundsätzliches, wenn man so will, Erkenntnisproblem ist.

Ende des 19.ten Jahrhunderts entwickelte sich auf der Basis von Poincarés Arbeiten zum sogenannten Dreikörperproblem und dem entdeckten instabilen oder auch chaotischem Verhalten nichtlinearer Gleichungen die Chaostheorie. Erkenntnis der Chaostheorie: die Vorhersagbarkeit des Verhaltens komplexer Systeme scheitert daran, dass die Anfangsbedingungen nicht exakt definierbar sind. Das Wort vom Schmetterling, der das Wetter beeinflussen kann, machte damals die Runde.

Was hat das nun mit Big Data zu tun? Das Datensammeln unterliegt keinem quantenmechanischen Effekt aber sicher Unschärfen, die verschiedenste Ursachen haben können.

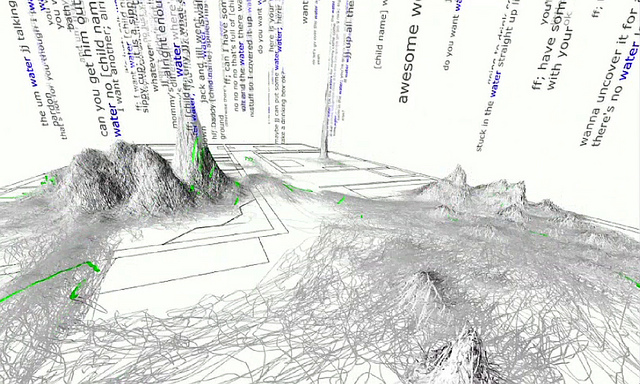

Sammlungen von Daten d.h. Zahlen, Informationen, Fakten, Bildern etc. können als Momentaufnahmen eines hochdimensionalen Schnittes oder auch einer Projektion eines noch viel höherdimensionalem Raumes, den wir Realität nennen, verstanden werden.

Die Situation ist mit der des bekannten Höhlengleichnisses von Platon vergleichbar, bei dem die Höhlenbewohner die Schatten, d.h. die Projektionen auf der Höhlenwand wahrnehmen. Sie halten die um mehrere Dimensionen (hier sehr einfach die fehlende dritte räumliche Dimension, Farbe) verkleinerte Projektion für die Realität. Wir laufen Gefahr, dass wir mit unseren Datensammlungen dem gleichen Irrtum unterliegen und daran glauben, die Wirklichkeit vollständig abzubilden, nur weil wir sehr viele Daten über sie gesammelt haben.

Bei vielen Datensammlungen wird in ihrem Lebenszyklus der sie erzeugende Schnitt oder die Projektion verändert z.B. wenn als fehlend erkannte „Dimensionen“ ergänzt werden oder Dimensionen entfallen. Auch Messverfahren oder bei der Datenverarbeitung eingesetzte Algorithmen werden geändert, Sensoren werden ausgetauscht. Schnittstellen, über die Daten importiert werden, können fehlerhaft sein. Beliebt ist auch, Randbedingungen, Grenzen der Gültigkeit von Zahlen, nicht mit zu erfassen und in Folge nicht erkennen zu können, wenn die Messwerte fragwürdig oder ungültig werden, weil sie außerhalb des Gültigkeitsbereiches der Algorithmen oder des Messbereiches liegen. Das führt zur zumindest partiellen Inkonsistenz der Datensammlungen, d.h. zu einem verzerrten, vieldimensionalem Bild.

Automatische Plausibilitätsprüfungen reichen hier nicht aus, wenn sie überhaupt durchgeführt werden, manuelle Überprüfungen sind nicht machbar oder nicht bezahlbar.

Bei der Berücksichtigung der Lebensdauer von Daten sieht es ganz besonders schlecht in Datensammlungen aus. Kein Datensammler löscht die mühsam gesammelten Daten gerne wieder. Datumsinformationen, die aussagen bis wann die Daten valide sind, oder wann sie gelöscht werden sollen, werden nur selten mitgeführt. Fällt der Pflegeaufwand noch der Kostenreduktion zum Opfer, dann sieht es schlecht um die Validität der Daten aus.

Bedarf es der menschlichen Interpretation bei der Zusammenfassung von Daten oder der Zuordnung zu zum Beispiel Personen, dann kommen Interpretationsspielräume oder einfach nur Irrtümer zu den sonstigen Ungenauigkeiten hinzu. Bei der Übergabe der Bearbeitungstätigkeit eines Sachbearbeiters an einen anderen in einer anderen Schicht oder an einen Nachfolger ist nicht sichergestellt, dass die Methode gleichbleibt.

Der professionelle Physiker wendet die Methode der Fehlerfortpflanzung an, um die Auswirkung von Ungenauigkeiten der Messgrößen auf die berechnete Zielgröße abzuschätzen. Für DataWarehouses, BI-Systeme oder Krankenhausinformationssysteme gibt es diese Abschätzung allerdings nicht. Dem Benutzer der Datensammlung wird die Unschärfe seiner Recherche nicht deutlich gemacht.

Die Auswirkungen von falschen Entscheidungen können bekanntlich enorm sein: die Vergabe von Krediten kann platzen, der Ermittlung von Versicherungspolicen auf der Basis von falschen Gesundheitsdaten kann teuer werden, die Fehleinschätzung als Terrorist kann mit einem Freiflug nach Guantanamo belohnt werden.

Es gilt die alte Regel der Datenverarbeitung: shit in, shit out

Smarte Wissenschaftler und Manager träumen schon davon, dass uns armen, vom Entscheidungsnotstand überforderten Menschen, immer mehr Entscheidungsalgorithmen den Mut zur Fehlentscheidung abnehmen werden.

Gerade wenn es um die Sammlung von personenbezogenen Daten geht, besteht die Gefahr, dass diese Daten, falsche wie korrekte, in falsche Hände geraten ein zusätzliches Risiko für den „Datenspender”. Wir haben in den letzten Monaten erfahren müssen, dass nicht nur Geheimdienste sondern auch gewöhnliche Kriminelle Zugang zu unseren Bankdaten, Gesundheitsdaten oder Aktivitäten die Promiskuität betreffend erlangen konnten, obwohl derartige Daten von ihren Verwaltern immer als sicher bezeichnet worden sind.

Es spricht also einiges dafür, dass es eine Unschärferelation auch für Daten gibt. Diese wird von folgender Art sein:

(1) ΔB * ΔU ≥q_NSA

(2) Δ€ * Δt ≥ q_NSA

das Produkt aus Änderung der Bedeutungslosigkeit von Daten multipliziert mit der Änderung in ihrer Ungenauigkeit ΔU ist immer größer als eine noch zu definierende Naturkonstante, nennen wir sie das „NSA-Quantum“ qNSA? Heißt: wird die Ungenauigkeit kleiner, so muss die Bedeutungslosigkeit der Daten steigen. Nimmt die Bedeutungslosigkeit ab, die Bedeutung also zu, dann wird leider die Ungenauigkeit größer. Oder in einer anderen Formulierung: je teurer die eingekauften Daten Δ€ waren, desto kürzer ist ihre Lebenszeit Δt. Das NSA-Quantum hat dann die Dimension von Euro-Sekunden.

Auch wenn leider ein derartiges Gesetz noch nicht nachgewiesen worden ist, sollten die Entscheider bei der Nutzung von „ihren“ Datensammlungen die angemessene Vorsicht walten lassen.

Es sieht so aus, dass einige große Datensammler ein nicht kontrollierbares Monstrum heranziehen: keiner weiß, wo die Daten herkommen, wie genau, richtig oder legal sie sind. Aber die Tatsache, dass sie existieren, wird hinlänglich als Beweis dafür verstanden werden, dass sie „so falsch nicht sein können“. Wenn dann der Einfachheit halber noch automatische Entscheidungen getroffen werden, dann gnade uns Gott.